Charte IA responsable pour ASBL : guide en 5 piliers

En bref

Guide pratique pour un usage responsable de l'IA dans les ASBL. Cadre structuré en 5 piliers (environnement, inclusion, éthique, transparence, innovation). Analyse énergétique comparative et charte modifiable CC BY 4.0.

Une charte conçue pour le réseau BeEducation

Au printemps 2025, j’ai eu le plaisir d’animer un atelier organisé par BeEducation, un réseau d’initiatives et d’associations engagées pour améliorer le système scolaire en Belgique. Créé en 2019, ce réseau fédère une quarantaine de membres actifs dans l’enseignement en Fédération Wallonie-Bruxelles, luttant contre les inégalités scolaires, le décrochage et le harcèlement, tout en promouvant l’inclusion et la citoyenneté responsable.

L’objectif de cet atelier : aider les participants — coordinateurs, chargés de projet, responsables communication d’ASBL du secteur éducatif — à appréhender les opportunités et les enjeux d’un usage responsable de l’intelligence artificielle.

Pour cet atelier, j’ai conçu une Charte d’usage de l’IA destinée au réseau BeEducation, un document pratique que je mets à disposition sous licence libre (Creative Commons CC BY 4.0) pour toute organisation souhaitant l’adapter à ses propres besoins.

📄 Charte d’usage responsable de l’IA

Document Word modifiable · Licence CC BY 4.0

Télécharger

Face à l’omniprésence de l’IA : choisir l’appropriation plutôt que le rejet

Que nous le souhaitions ou non, l’intelligence artificielle s’invite désormais dans la plupart de nos outils quotidiens : moteurs de recherche, suites bureautiques, messageries, plateformes collaboratives. Face à cette réalité, deux attitudes sont possibles : le rejet en bloc, ou l’appropriation critique.

J’ai choisi la seconde voie — et c’est celle que j’encourage dans mes accompagnements. Non pas par enthousiasme technophile aveugle, mais par pragmatisme : les ASBL, souvent contraintes par des ressources humaines et financières limitées, peuvent trouver dans ces outils un soutien précieux pour accomplir leur mission.

Dans un monde idéal, le secteur à profit social bénéficierait d’un soutien public à la hauteur de son impact sociétal. En attendant, il nous appartient de composer avec les moyens disponibles — y compris technologiques — tout en gardant un regard lucide sur leurs limites et leurs risques.

C’est précisément l’objectif de cette charte : offrir un cadre pour utiliser l’IA de manière réfléchie, sans naïveté ni rejet systématique.

💡 Repères historiques : l’IA avant ChatGPT

- 1950 — Alan Turing publie Computing Machinery and Intelligence et propose le Test de Turing

- 1956 — Conférence de Dartmouth : le terme “intelligence artificielle” est formalisé

- 1958 — Frank Rosenblatt conçoit le Perceptron, précurseur des réseaux de neurones

- 1966 — ELIZA, premier agent conversationnel, simule un dialogue thérapeutique

- 1970-80 — Essor des systèmes experts (MYCIN), suivi d’un “hiver de l’IA” (réduction des financements)

- 1990s — Détection de fraude bancaire, filtres anti-spam, diagnostic assisté en radiologie

- 2000s — GPS prédictif, recommandations personnalisées (Netflix), traduction automatique (Google Translate, 2006)

- 2010s — Assistants vocaux (Siri), reconnaissance faciale, accessibilité (sous-titrage automatique, lecteurs d’écran intelligents)

- 2017 — Détection précoce de rétinopathie diabétique et cancers de la peau par deep learning

- 2022+ — IA générative (ChatGPT, Claude, Mistral) accessible au grand public

L’intelligence artificielle recouvre en réalité plusieurs familles distinctes : l’IA prédictive (anticiper un comportement, une tendance), l’IA prescriptive (recommander une action optimale), et l’IA générative (produire du contenu nouveau). C’est cette dernière, portée par les grands modèles de langage (LLM), qui a provoqué le basculement de 2022 : pour la première fois, des capacités jusqu’alors réservées aux spécialistes deviennent accessibles au grand public — et c’est précisément cette démocratisation qui cristallise aujourd’hui les débats éthiques, environnementaux et sociétaux.

L’IA, un amplificateur d’impact social pour les ASBL

Bien utilisée, l’intelligence artificielle peut devenir un véritable levier pour les organisations à but non lucratif. Elle permet de réduire les tâches répétitives, de renforcer certaines compétences, et surtout — pour des équipes souvent réduites — de libérer du temps pour ce qui compte : la mission sociale.

7 catégories d’usage concrètes

Durant l’atelier, nous avons exploré sept grandes familles d’applications de l’IA pour les ASBL :

Génération de contenu : rédaction assistée (demandes de subventions, rapports d’activité, newsletters), création de calendriers éditoriaux, traduction, et optimisation SEO.

Productivité et collaboration : transcription automatique de réunions, génération de résumés et points d’action, assistance à la gestion de projet.

Analyse et traitement de données : aide aux formules Excel complexes, visualisation automatique, détection d’anomalies et rapports de suivi.

Relation avec les parties prenantes : automatiser les réponses fréquentes et le suivi (financeurs, donateurs, bénévoles) pour libérer du temps aux échanges humains à forte valeur ajoutée.

Documents intelligents : interrogation de documents volumineux (règlements, contrats, études), classification automatique, moteur de recherche interne.

Recherche et veille stratégique : suivi des appels à projets et opportunités de financement, veille sectorielle, synthèse d’études scientifiques.

Automatisations sur mesure (niveau avancé) : intégration de l’IA dans vos outils existants (CRM, ERP, plateforme de gestion), création de workflows automatisés pour les tâches récurrentes, veille sectorielle avec alertes personnalisées.

Les 7 catégories d’usage de l’IA identifiées lors de l’atelier BeEducation

Pourquoi une charte est-elle nécessaire ?

Choisir ses usages : toutes les tâches n’ont pas le même coût

Au sein même de l’IA générative, les écarts d’impact environnemental sont considérables. Générer du texte, analyser une image ou produire une vidéo ne mobilisent pas les mêmes ressources — et de loin.

Pour une ASBL, le choix n’est donc pas “IA ou pas d’IA”, mais “quelle tâche, pour quel gain de mission ?”

Le principe de proportionnalité

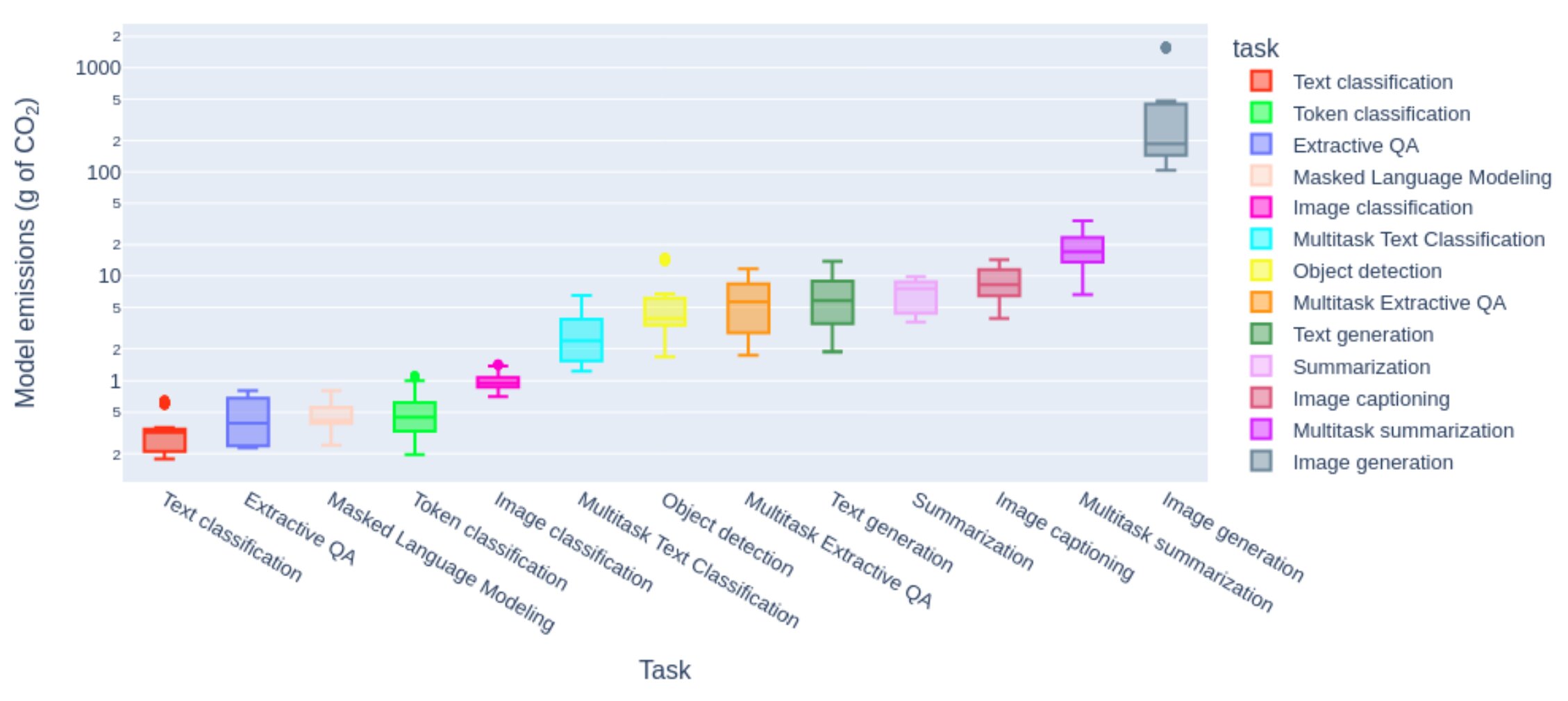

Selon l’étude de Luccioni et al. (2023) sur la consommation énergétique des modèles d’IA, l’écart entre les tâches est considérable :

Source : Luccioni et al. (2023), “Power Hungry Processing: Watts Driving the Cost of AI Deployment?”

| Usage | Coût relatif | Recommandation |

|---|---|---|

| Texte (résumé, tri, réponse) | 1× | Usage raisonné, sans excès |

| Analyse d’image | 10–50× | Avec intention |

| Génération d’image | 100–1 000× | À éviter sauf exception justifiée |

| Génération vidéo | 1 000–10 000× | À proscrire dans la majorité des cas |

L’ordre de grandeur compte : ces écarts énergétiques varient considérablement selon les modèles, l’infrastructure et la résolution, mais restent significatifs. La génération d’images consomme de 100 à 1000 fois plus d’énergie qu’une tâche textuelle, et la vidéo multiplie encore cet écart.

Tous les modèles ne se valent pas

Au-delà du type de tâche, le choix du modèle compte. Mobiliser un modèle frontier (les plus puissants et énergivores du marché) pour une tâche élémentaire — résumer un email, reformuler une phrase — constitue une disproportion significative entre la puissance déployée et le besoin réel.

| Catégorie | Exemples | Consommation |

|---|---|---|

| Compacts (1-3B paramètres) | Llama 3.2 1B, Phi-3-mini | 1× (référence) |

| Légers (7-8B paramètres) | Mistral 7B, GPT-4o mini, Claude Haiku | 4-6× |

| Moyens (70B paramètres) | Llama 3.3 70B | 20-30× |

| Frontier (>100B paramètres) | GPT-5, Claude Opus, Mistral Large, Llama 405B | 50-100×+ |

💡 La bonne nouvelle : des modèles légers performants

Grâce aux techniques de distillation et de quantization, les modèles légers atteignent aujourd’hui 80-90% des performances des modèles lourds. Un résumé de réunion, une reformulation, une traduction ? Les modèles légers comme GPT-4o mini ou Claude Haiku suffisent largement — pour 10 à 50 fois moins d’énergie.

Sources : Samsi et al., AI Energy Score, Stanford AI Index 2025. Ces ordres de grandeur peuvent varier d’un facteur 10 selon le matériel et le contexte.

Ce que cela signifie pour votre organisation

Pour une ASBL, la stratégie responsable n’est pas de fuir l’IA, mais de proportionner l’usage à la valeur ajoutée réelle :

- Texte → usage pertinent quand il libère du temps pour la mission : synthèses, reformulation, aide à la rédaction

- Image → à réserver aux communications à fort impact, quand une banque d’images libres ne suffit pas

- Vidéo générée → à proscrire sauf cas exceptionnel où aucune alternative n’existe

Cette logique rejoint un principe familier aux organisations à mission : concentrer les ressources là où elles démultiplient l’action, pas là où elles impressionnent.

🧭 Un test simple avant chaque usage

Cet usage de l’IA permet-il de dégager du temps humain ? D’améliorer l’accès ou la qualité du service ? Sans exclure une partie du public ?

Si aucune réponse n’est positive, l’usage n’est pas prioritaire.

Des défis à ne pas occulter

Au-delà de l’environnement, d’autres enjeux méritent notre vigilance :

La désinformation prend une ampleur nouvelle avec les deepfakes et les contenus générés non vérifiés. La facilité de production de faux contenus — textes, images, voix clonées — rend la vérification des sources plus cruciale que jamais, particulièrement pour des organisations dont la crédibilité est un capital essentiel.

La fracture numérique reste préoccupante. En Belgique, 40% de la population est en situation de vulnérabilité numérique selon le Baromètre de l’inclusion numérique 2024 de la Fondation Roi Baudouin. Malgré des progrès (46% en 2021), les inégalités persistent : 54% des demandeurs d’emploi et 42% des familles monoparentales peinent à accéder aux services numériques. Une ASBL qui digitalise ses services doit veiller à ne pas exclure une partie de son public.

Les biais algorithmiques ne sont pas une abstraction théorique. En 2018, Amazon a dû abandonner un outil de recrutement qui pénalisait systématiquement les CV féminins — l’algorithme avait appris les biais présents dans dix ans de données historiques. Pour une ASBL travaillant avec des publics vulnérables, utiliser une IA sans questionnement critique revient à potentiellement reproduire les discriminations qu’elle combat.

La protection des données appelle également une vigilance renforcée. Le RGPD impose des règles strictes, mais les IA génératives posent de nouvelles questions : où vont les données saisies dans un prompt ? Comment garantir la confidentialité des informations sur les bénéficiaires ?

Un principe cardinal : l’IA peut assister, jamais décider seule lorsqu’un impact direct sur des personnes est en jeu (orientation, sélection, évaluation). Ce principe est consacré par le Règlement européen sur l’IA (Art. 14) et le RGPD (Art. 22).

Ces enjeux nous ont conduits, avec les participants de l’atelier, à concevoir un cadre structurant.

Les cinq piliers de la charte

La charte s’articule autour de cinq engagements fondamentaux, inspirés du format de la Charte du Numérique Responsable de l’Institut du Numérique Responsable.

1. Environnement : un usage sobre et écologiquement responsable

Privilégier les moteurs de recherche classiques pour les requêtes simples

Réserver l’IA aux situations où elle apporte une réelle valeur ajoutée

- Formuler des requêtes précises et ciblées

Restreindre les usages très énergivores (génération d’images, vidéos) aux projets à forte plus-value sociale

Pour les plus avancés : mesurer l’empreinte carbone via

EcoLogits Calculator

ou privilégier des modèles open-source sobres (ex. : Mistral 7B)

2. Accessibilité et inclusion : ne laisser personne de côté

Veiller à ce que nos usages de l’IA ne renforcent pas les fractures numériques existantes

Former les équipes à une utilisation éclairée, critique et responsable

S’assurer que les contenus générés restent accessibles aux personnes en situation de handicap

- Mobiliser l’IA comme outil d’accessibilité et d’inclusion sociale

3. Éthique et gouvernance : des pratiques responsables

- Respecter le RGPD et anonymiser les données sensibles

- Rester vigilant face aux biais algorithmiques

Définir clairement ce qui peut être délégué à l’IA et ce qui doit rester humain

- Vérifier systématiquement les contenus générés avant diffusion

4. Transparence et confiance : communiquer sur ses usages

Informer clairement lorsque l’IA est utilisée dans les contenus ou services

- Expliquer les choix d’outils et leurs implications

- Partager les apprentissages avec d’autres acteurs du secteur

Mettre en place des mécanismes de retour en cas d’usage problématique

5. Innovation responsable : l’humain au centre

- Explorer des applications qui renforcent l’impact social réel

- Évaluer régulièrement la plus-value effective des outils utilisés

Garder l’humain au centre : l’IA reste un outil, jamais un substitut à l’engagement

Contribuer aux réflexions collectives sur l’encadrement éthique de l’IA

Un document vivant, à adapter à vos besoins

Cette charte n’est pas gravée dans le marbre. Elle se veut un point de départ, un cadre de réflexion que chaque organisation peut et doit adapter à sa réalité propre : sa mission, ses publics, ses moyens, son niveau de maturité numérique.

Le format Word est volontairement choisi pour faciliter cette appropriation. Vous pouvez librement :

- Modifier les engagements selon vos priorités

- Ajouter des éléments spécifiques à votre secteur d’activité

- Supprimer les points « avancés » si votre organisation débute

- Compléter avec vos propres bonnes pratiques

Remerciements

Je tiens à remercier chaleureusement l’équipe de BeEducation pour l’organisation de cet atelier et la qualité des échanges avec les participants. C’est de cette intelligence collective qu’est née cette charte.

Note : la structuration de cette page web a bénéficié de l’assistance de Claude Code d’Anthropic, et les recherches documentaires ont été facilitées par Perplexity.

Ressources complémentaires

Pour aller plus loin sur les enjeux environnementaux du numérique et de l’IA :

- L’empreinte carbone du numérique : comparable à l’aviation civile

- Votre ordinateur pèse 800 kg : l’impact caché de nos appareils

- Charte du Numérique Responsable (INR)

- EcoLogits Calculator

- Framamia - Comprendre l’IA pour la démystifier

Et maintenant ?

Si cette charte vous inspire, vous pouvez :

- L’adapter à votre organisation et la partager avec votre équipe

- La diffuser auprès d’autres ASBL de votre réseau

- Contribuer à son amélioration en partageant vos retours d’expérience

Cet article reflète l’état des connaissances en janvier 2026. Le domaine évoluant rapidement, il sera mis à jour régulièrement.